فایل روبوت robots.txt چیست؟ نحوه ساخت فایل robots.txt چگونه است؟ بهترین و مناسب ترین فایل روبوت برای وردپرس و جوملا چیست؟ پاسخ به همه این پرسشها را میتوانید در این مقاله از سایت میزفا مطالعه نمایید. همچنین در این مقاله ۸ مثال کاربردی درباره فایل روبوت (ربات) گفته شده است. همراه باشید.

سرفصلهای پست

- 1 فایل robots.txt چیست

- 2 فایل robots.txt باید در چه آدرسی قرار دهیم؟

- 3 نحوه ساخت فایل robots.txt

- 4 نمونه دستورات در فایل Robots.txt

- 4.1 مثال یک – عدم دسترسی به کل سایت

- 4.2 مثال دو – دسترسی به کل سایت

- 4.3 مثال سه – عدم دسترسی به دایرکتوری خاص

- 4.4 مثال چهار – اولویت ربات ها

- 4.5 مثال پنج – Regular Expression

- 4.6 مثال شش – تعیین استثنا برای دسترسی به محتوای دایرکتوری

- 4.7 مثال هفت – اشتباه رایج

- 4.8 مثال هشت – عدم دسترسی به آدرسی با کاراکتر خاص

- 5 تست فایل robots.txt در سرچ کنسول گوگل

- 6 چند نکته پایانی درباره فایل robots.txt

فایل robots.txt چیست

فایل robots.txt یک فایل متنی است که بهوسیله آن خطمشی برای ربات موتورهای جستجو تعیین میکنیم که چه آدرسهایی را خزش و ایندکس کنند و چه آدرسهایی را خزش و ایندکس نکنند. توجه داشته باشید که ماهیت خزش با ایندکس فرق دارد. یک ربات باید در ابتدا خزشی را صورت بدهد و سپس تصمیم میگیرد که آن را در دیتابیس موتورهای جستجو ذخیره کند یا نه. اگر ذخیره شود عمل ایندکس رخداده است. ما در این مقاله از سایت میزفا به نحوه ایجاد و ساخت فایل robots.txt میپردازیم و شما با خواندن این مقاله صرف نظر از اینکه چه نوع CMS (وردپرس، جوملا و …) دارید، میتوانید این فایل را ایجاد و مدیریت کنید.

موتورهای جستجو با خزیدن در میان صفحات سایت شما، آنها را ایندکس میکند و با دنبال کردن لینکها وارد صفحات یا سایتهای دیگر میشوند. هر ربات استانداردی قبل از خزیدن صفحهای از یک دامنه، ابتدا فایل robots.txt را میخواند و بر اساس دستورات موجود در این فایل، اجازه خزیدن را پیدا میکند تا بتواند ایندکس را انجام دهد. پس باید دقت داشته باشید که چه صفحاتی را برای خزیدن منع میکنید چراکه اگر بهاشتباه صفحات مهم خود را مخصوصاً صفحات فرود یا همان لندینگ پیج را از طریق این فایل برای رباتها مسدود کنید ضربه بدی به سئو سایت و درنتیجه تجارت آنلاین خود وارد میکنید. (اهمیت و نحوه ساختن صفحات فرود یا لندینگ پیج را میتوانید به همراه مثال در مقاله جامع صفحه فرود چیست بخوانید)

فایل robots.txt مختص رباتها است اما جالب است بدانید که چنین فایلی برای انسانها هم نوشته میشود. این فایل humans.txt نام دارد و حاوی پیامی برای کاربران و بازدیدکنندگان سایت شما است و اصولاً به زبان انگلیسی نوشته میشود.

نمونه فایل robots.txt و فایل humans.txt برای سایت گوگل:

https://www.google.com/robots.txt

https://www.google.com/humans.txt

فایل robots.txt یا متاتگ روبات

اگر میخواهید آدرسی از صفحات و لینکهای آن توسط روبات بررسی شود اما در نتایج جستجو نمایش داده نشود، درنتیجه باید بجای فایل robots.txt از متاتگ ربات استفاده کنید. اگر قصد دارید این روش را به شکل بهینه انجام دهید مقاله متاتگ robots ما را حتماً بخوانید تا به نکات جالبی درباره این متاتگ دست پیدا کنید.

فایل robots.txt باید در چه آدرسی قرار دهیم؟

بعد از ساخت فایل robots.txt با فرمت ASCII یا UTF-8 این فایل حتماً در آدرس http://domain.com/robots.txt مورد دسترسی رباتها قرار گیرد (بجای domain.com نام دامنه سایت خود را قرار دهید). حال دو نکته درباره این موضوع:

- اگر ربات خزنده قصد داشته باشد به زیر دامنههای ما سر بزند باید برای هر زیردامنه یک فایل robots.txt جداگانه ایجاد کنیم.

- اگر سایت شما هم با www و هم بدون www باز میشود باید فایل robots.txt را در هر دو حالت یکسان تنظیم کنید؛ همین موضوع برای http و https هم صدق میکند ولی به این نکته توجه داشته باشید که اگر سایت به این شکل در دسترس باشد باعث ایجاد محتوای تکراری میشود که برای سئو داخلی سایت بهشدت ضرر است و یکی از دلایل پنالتی شدن سایت در گوگل میباشد، چراکه تمام زیر دامنهها از نگاه گوگل یک سایت مجزا محسوب میشود. ولی درباره این فایل بدانید که اگر زیر دامنههای شما جداگانه باز میشود گوگل برای خواندن فایل robots.txt دامنه http را اولویت قرار میدهد.

http://www.site.com https://www.site.com http://site.com https://site.com

- نکته مهم دیگر اینکه که فایل robots.txt حتما باید با حروف کوچک نوشته شود. این فایل همانند URL نام این فایل نسبت به حروف بزرگ و کوچک حساس است. به عنوان مثال آدرسهای زیر کاملا با هم فرق دارند و فقط اولین آدرس صحیح میباشد.

mizfa.com/robots.txt mizfa.com/robotS.txt mizfa.com/robots.TXT mizfa.com/Robotx.txt mizfa.com/ROBOTS.txt

چند مثال برای درک بهتر مکان صحیح فایل robots.txt

| آدرس فایل robots.txt | معتبر بودن فایل در آدرسهای | معتبر نبودن فایل در آدرسهای | توضیحات بیشتر |

| http://example.com/robots.txt | http://mizfa.com/ http://mizfa.com/blog/file |

http://mizfa.academy/

|

آدرس فایل robots.txt برای زیر دامنه ها و دامنههایی که با پورت باز میشوند معتبر نیست و فقط برای همان دامنه و تمام فولدرهای آن معتبر است. |

| http://www.example.com/robots.txt | http://www.mizfa.com/ | http://mizfa.com/ http://service.www.mizfa.com/ http://www.mizfa.academy/ |

هر زیر دامنه و همینطور دیگر ورژنهای زیر دامنه باید یک فایل robots.txt مجزا از فایل robots.txt دامنه اصلی داشته باشد. این موضوع در مورد دیگر ورژنهای دامنه اصلی هم صدق میکند مگر آنکه ریدایرکت اصولی صورت گیرد که در این صورت نیازی به فایل robots.txt مجزا نیست. |

| http://example.com/blog/robots.txt | چنین آدرس فایلی اصلا توسط رباتها خزش نمیشود. |

اگر در مورد جدول فوق ابهام داشتید با کمال میل در بخش کامنت این مطلب پاسخگوی شما هستیم.

نحوه ساخت فایل robots.txt

اگر بعد از مراجعه به آدرس http://domain.com/robots.txt خطایی مشاهده کردید یعنی سایت شما فایل robots.txt را ندارد. برای ساخت robots.txt کافی است به کنترل پنل هاست سایت مراجعه کنید، حال اگر کنترلپنل هاست از نوع سیپنل باشد محیطی شبیه عکس زیر دارد.

در ریشه یا روت سایت یک فایل ساده ایجاد کرده و فرمت و نام آن را robots.txt درج کنید. گوگل در مقاله Create a robots.txt file به آموزش ساخت فایل robots.txt اشاره کرده است و ما هم در ادامه این مقاله به نمونه دستورات در فایل Robots.txt اشاره خواهیم کرد اما قبل از هرچیز بهتر است ابتدا به تعریف سه کلمهی کلیدی بپردازیم.

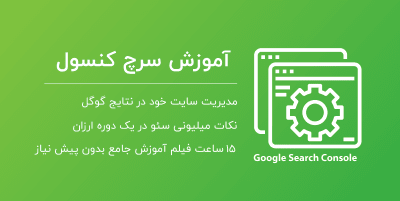

User-agent : نام ربات موردنظر را جلوی این عبارت مینویسیم که البته حساس به حروف کوچک و بزرگ نیست ( به عبارت دیگر non case sensitive است). با استفاده از کیورد user-agent میتوانید ربات خاصی را هدف گرفته یا بهطورکلی، دستوری را خطاب به همه آنها درج کنید. گاهی بعضی از موتورهای جستجو رباتهای مختلفی نیز دارند همانند موتور جستجوی گوگل که برای تصاویر، اخبار و موارد دیگر ربات خاص خود را دارد. در ادامه مثالهای متنوعی خواهیم زد تا بهتر به این امر پی ببرید.

لیست رباتهای معروف موتورهای جستجو در عکس زیر:

اگر قصد دارید اطلاعات بیشتری درباره رباتهای گوگل کسب کنید این مقاله سایت گوگل را مطالعه فرمایید.

Disallow : مقابل این کیبورد، دایرکتوریای را درج میکنید که قصد ندارید توسط ربات ایندکس شود. بعد از عبارت User-agent میتوانید در هرچند بار که لازم باشد از Disallow استفاده نمایید. به این نکته مهم توجه کنید که ربات موتورهای جستجو به حروف کوچک و بزرگ در دایرکتوریها حساس هستند. در ادامه مثالهای متنوعی خواهیم زد تا بهتر به این امر پی ببرید.

Allow : برعکس دستور Disallow است هرچند دستور Allow غیررسمی است ولی توسط اکثر رباتهای معروف شناختهشده است.

نمونه دستورات در فایل Robots.txt

قبل از هرچیز بدانید که:

* به همه اشاره دارد، مثلاً همهی رباتها یا همهی کاراکترها. در مثالهای زیر به خوبی متوجه کاربرد * میشوید.

/ به تنهایی به معنی همهی آدرسها است.

$ به پایان مسیر یک URL اشاره میکند.

مثال یک – عدم دسترسی به کل سایت

در نتیجه در خط اول مثال زیر با درج * همه ربات های موتورهای جستجو را خطاب قرار میدهیم و در خط دوم با درج / به عدم خزش و ایندکس تمام آدرس های دامنه اشاره میکنیم. بنابراین دستور زیر یعنی: هیچیک از موتورهای جستجو مجاز به خزیدن سایت شما نباشند.

User-agent: * Disallow: /

مثال دو – دسترسی به کل سایت

دستور زیر برعکس دستور بالا میگویید همه رباتهای موتورهای جستجو به کلیه آدرسهای سایت دسترسی دارند.

User-agent: * Disallow:

خلاصه تصویری از دو مثال بالا

مثال سه – عدم دسترسی به دایرکتوری خاص

دستور زیر به این معناست که ربات گوگل به پوشه blog و همه زیرپوشههای blog دسترسی ندارد. درواقع عدم دسترسی هم شامل آدرس mizfa.com/blog و هم شامل آدرسهای بهمانند mizfa.com/blog/example میشود. در این شرایط بقیه رباتها بهجز ربات گوگل دسترسی به این دایرکتوری را دارند.

User-agent: googlebot Disallow: /blog

مثال چهار – اولویت ربات ها

همانطور که گفتیم موتورهای جستجو ممکن است تعداد رباتهای زیادی برای موارد خاص داشته باشند برای همین اولویت هم برای آنان مهم است. درصورتیکه در فایل robots.txt دستوراتی را درج کرده باشید که چند بلاک مختلف آنها برای یک ربات (خزنده) صادق باشد، ربات موتور جستجو همیشه دستوری را که بهطور واضحتر به آن ربات خاص اشاره میکند انتخاب کرده و دستورات همان بخش را اجرا خواهد کرد. مثلاً فرض کنید اگر فایل robots.txt همانند دستور زیر یک بلاک مخصوص Googlebot و یک بلاک مخصوص Googlebot-Video وجود داشته باشد. در این حالت اگر ربات عکس گوگل (Googlebot-Image) وارد سایت شما شود، در میان این بلاکها از اولی پیروی خواهد کرد و اگر ربات ویدیو گوگل (Googlebot-Video) وارد سایت شود، از بلاک دومی پیروی خواهد کرد و دستورات بلاک اولی را نادیده گرفته چراکه بلاک دومی برای آن در اولویت است.

User-agent: Googlebot Disallow: /Photo User-agent: Googlebot-Video Allow: /blog

مثال پنج – Regular Expression

شما میتوانید از عبارات منظم (Regular Expression) هم برای استفاده در دستورات فایل robots.txt استفاده کنید. البته این عبارات منظم به شکل رسمی در این فایل تعریفنشدهاند ولی اکثر رباتهای معروف در دنیا از عبارات منظم نیز پشتیبانی میکنند. مثلاً در دستور نیز اشارهشده که کلیه رباتها به فایلها با پسوند pdf که در فولدر (دایرکتوری) test وجود دارند، نباید دسترسی داشته باشند.

User-agent: * Disallow: /test/*.pdf$

مثال شش – تعیین استثنا برای دسترسی به محتوای دایرکتوری

حال قصد داریم کمی درباره وردپرس حرف بزنیم و یک فایل robots txt برای وردپرس به شکل بهینه شده و مناسب ایجاد کنیم. دستور زیر که در بسیاری از سایتهای وردپرس استفاده میشود به این معناست که تمام رباتها به پوشه wp-admin دسترسی نداشته باشند ولی به فایل admin-ajax.php که در این پوشه هست دسترسی پیدا کنند. البته بودن چنین دستوراتی در فایل robots.txt ضرری هم ندارد هر چند ربات توانایی وارد شدن به محیط ادمین وردپرس را ندارد ولی خطا در کدنویسی هم از سمت گوگل و هم از سمت ما طبیعتا امکانپذیر است. اگر توجه کرده باشید ما در این مقاله یک بار از کیورد User-agent استفاده کردیم و سپس ۲ خط دستور وارد کردیم، شما میتوانید به تعداد دلخواه دستورات لازم را در هر خط وارد نمایید.

User-agent: * Disallow: /wp-admin/ Allow: /wp-admin/admin-ajax.php

مثال هفت – اشتباه رایج

یکی دیگر از دستورات رایج و اشتباه از نگاه یک متخصص سئو در فایل robots.txt وردپرس که در بسیاری از سایتهای معروف ایرانی استفاده میشود کدهای زیر میباشند. بنده شخصاً در هیچیک از سایتهای معتبر خارجی که دارای سیستم مدیریت محتوا وردپرس هستند چنین کدهایی را پیدا نکردم. عدم دسترسی به wp-includes که در آن یک سری فایلهای مهم مثل جی کوئری است باعث میشود سایت به آن شکلی که باید برای موتور جستجو نمایش دهد، خروجی نگیرد. سایتهای مثل یوآست، نیل پتل، searchengineland و دهها سایت معروف وردپرس که در مبحث سئو صاحبنظرهای جهانی هستند از چنین دستوراتی که باعث عدم دسترسی به فایلهای wp-includes میشود استفاده نمیکنند، حتی سایت یوآست در این مقاله اشارهکرده چنین دستوراتی اشتباه است و باعث مسدود شدن رباتها به بعضی فایلها میشود که برای سئو سایت خوشایند نیست.

User-agent: * Disallow: /wp-admin/ Disallow: /wp-includes/[box type=”info” align=”” class=”” width=””]نکته: در مثال فوق disallow کردن /wp-includes/ را به عنوان اشتباه رایج معرفی کردهایم، نه /wp-admin/. درج /wp-admin/ در فایل robots.txt وردپرس یک روش پیشفرض است و ترجیح دادیم در هرمثال آن را قرار دهیم. (البته Disallow کردن /wp-admin/ نسخهای نیست که بشود برای همه وبسایتها پیچید و کاملاً بستگی به سایت دارد)[/box]

مثال هشت – عدم دسترسی به آدرسی با کاراکتر خاص

دستور زیر وقتی کاربرد دارد که شما در آدرسهای خود کاراکتری مانند ? را داشته باشید چراکه گاهی به دلیل مشکلات فنی در سایت، مقاله شما ممکن است با آدرسهای مختلف و با مقادیر متفاوت انتشار پیدا کند. به همین منظور دستور زیر را به شکل موقت درج میکنید تا رباتها آدرسهای دارای کاراکتر علامت سؤال را ایندکس نکنند.

User-agent: * Disallow: /*?

در مثال پایین با درج $ تأکید میکنیم که اگر در انتهای آدرسی علامت سوال (?) بود، آن آدرس باید Disallow شود. در نتیجه مثال پایین یعنی هیچ رباتی اجازهی خزش آدرسهایی که با ? تمام میشوند را ندارند. در این شرایط آدرسهایی که با ? به اتمام نمیرسند در نظر گرفته نمیشوند.

User-agent: * Disallow: /*?$

اگر به دنبال مثال های بیشتری هستید مقاله Robots.txt Specifications گوگل هم میتواند برای شما مفید باشد.

تست فایل robots.txt در سرچ کنسول گوگل

در نهایت بعد از ساختن فایل robots.txt نوبت به تست و صحت کارکرد آن میرسد.

[box type=”warning” align=”” width=””]آپدیت 2020: توجه داشته باشید در ورژن جدید سرچ کنسول امکان تست فایل robots.txt وجود ندارد. برای تست این فایل از این لینک وارد شوید. اگر با خطایی مواجه شدید URL سایت (مثلا http://mizfa.com) را در سرچ کنسول به عنوان property جدید اضافه کنید و مجدد آزمایش کنید.[/box]

گوگل در قسمتی از سرچ کنسول خود شرایط رایگانی برای تست فایل robotx.txt فراهم کرده است. به این منظور وارد سرچ کنسول (وبمسترتولز) شوید. ( اگر به دنبال یادگیری حرفه ای سرچ کنسول هستید حتما سری به آموزش سرچ کنسول وبسایت میزفا بزنید)

در منوهای موجود سرچ کنسول “Crawl” را انتخاب کنید.

سپس زیرمنوی “robots.txt Tester.” را انتخاب کرده تا ابزار تست این فایل را مشاهده کنید.

در سمت راست دستوراتی را مشاهده میکنید که در فایل robots.txt درج کرده بودید. این نشان دهنده این است که شما به درستی این فایل را ایجاد کردهاید و مکان آن صحیح است.

اگر قصد دارید مطمئن شوید که آیا ربات به آدرسی دسترسی دارد یا نه، میتوانید در قسمت “Enter a URL to test if it is blocked” آدرس را وارد کنید و نوع ربات گوگل را هم مشخص نمایید و دکمه تست را بزنید

اگر با پیغام “ALLOWED” مواجه شدید به معنای آن است که ربات گوگل به آن دایرکتوری دسترسی دارد در غیر این صورت با پیغام “BLOCKED” روبهرو میشوید که بنی بر آن است که ربات دسترسی به آن آدرس (دایرکتوری) را ندارد.

اطلاعات بیشتر درباره تست فایل robots.txt در سایت گوگل مشاهده کنید.

چند نکته پایانی درباره فایل robots.txt

- رباتهای خزنده و یا بعضی رباتهای موتورهای جستجو ممکن است به دستورات موجود در فایل robots.txt که درجشده را نادیده بگیرند. مخصوصاً رباتهای اسپم یا مالور (malware robots) که برای آسیبپذیری، سایتها را بدون توجه به این مسائل اسکن میکنند. و به دنبال ایمیل کاربران یا موارد دیگر هستند.

- ممکن است متدهای فایل robots.txt را با متاتگ robots به اشتباه بگیرید برای همین پیشنهاد میشود که حتما مقاله کوتاه و مفید تفاوت فایل robots.txt با متاتگ robots را بخوانید.

- موتورهای جستجو محتوای فایل robots.txt را کَش میکنند اما معمولا محتوای کش شده را روزی حداقل یک بار به روز رسانی میکنند. با این حال شما اگر تمایل دارید بعد از تغییرات در این فایل، موتورهای جستجو سریعتر کش را آپدیت کنند فایل خود را در این آدرس گوگل ارسال کنید. صحبت از Cache شد، آیا میدانستید که کش کردن سایت تأثیرات فوقالعادهای روی سرعت وبسایتهایی با ترافیک بالا دارد؟ راه و چاهش در مقاله بهترین افزونه کش وردپرس!

خب امیدوارم از آموزش ساخت فایل robots.txt و نکات پیرو آن استفاده کردهباشید و صرف نظر از اینکه از وردپرس، جوملا یا هر CMS دیگری استفاده میکنید بتوانید براحتی robots.txt بسازید. هرچند برای ایجاد فایل robots.txt برای وردپرس و دیگر سی ام اس ها مثل جوملا مثالهایی ارائه دادیم؛ اما فراموش نکنید که امکان ندارد یک فایل را به عنوان بهترین فایل robots.txt مناسب وردپرس یا CMSهای دیگر درنظر گرفت و برای همهی سایتها از همان یک فایل استفاده کرد.

راستی اگر شما هم تجربهای درباره نحوه کارکرد و ساخت فایل robots.txt دارید خوشحال میشیم در نظرات به اشتراک بگذارید 🙂

92 پاسخ

سلام وقتتون بخیر

Disallow: /readme.html

Disallow: /cart/

Disallow: /checkout/

Disallow: /likes/

Disallow: /my-orders/

Disallow: /dashboard/

Disallow: */page/*

Disallow: *?filter*

معنای این تگ ها که تو فایل روبوت قرار میدهند چیه؟

سلام وقت بخیر و شادی.

پیشنهاد میشه کمی برای خودتون وقت بذارید و مقاله رو مطالعه کنید تا متوجه بشید.

ممنونم از حضور شما

سلام وقتتون بخیر بخاطر سایت فوق العادتون ممنونم. ببخشید یک راهنمایی خیلی کوچیک میخوام. من یک سری عکس داخل وردپرسم هست که نمیخوام در نتایج گوگل ایندکس بشن. قصد داشتم همون هارو ویرایش بزنم و براشون مثلا پسوند png لحاظ کنم و توسط ربات txt محدودشون کنم. اما واقعا زمان بر و دشواره. توی بخش رسانه ی وردپرس دیدم که میشه یک دسته بندی برای تصاویر ایجاد کرد. آیا امکانش هست که اون تصاویر مد نظر خودم رو در اون دسته بندی قرار بدم و اون دسته بندی رو محدود کنم؟ اگر امکانش هست ممنون میشم فقط بتونید کد دستوریش رو برام بفرستید تا در فایل robots.txt سایتم قرار بدم چون خیلی حساسه نمیتونم سرخود کاری کنم باهاش. ممنونم از شما

سلام

امیدوارم خوب باشی

میتونی اون عکس ها رو بررسی داخل یک زیر دامنه و کلا زیردامنه رو با این فایل ربات مسدود کنی، همینطور میتونی این عکس ها رو در یک پوشه خاص درج کنی و دوباره ادرس پوشه رو در فایل ربات بدی و دوباره مسدود کنی.

اگر فکر میکنی سخته و یا ممکنه خطا کنی در سایت هایی مثل پونیشا دنبال متخصص سئو بگرد تا برات انجام بده.

سلام خسته نباشید یک سوالی داشتم کسایی که از ووکامرس استفاده می کنند می تونن دایرکتوری cart و دایرکتوری checkout رو در فایل robots به صورت disallow کنند منظورم اینه که این کار مشکلی نداره البته منظورم کسایی هستش که سیاستشون اینه که بیشتر بودجه خزش گوگل رو روی صفحات اصلی بزارند

سلام حسین

خود ووکامرس این صفحات رو به کمک تگ noindex میکنه و نیازی به استفاده از این فایل نیست.

سلام و وقت بخیر

من آدرس پایین رو که وارد می کنم نشون میده که سایت من فایل robots رو داره و اونو نشون میده اما از روت سایتم پیداش نمیکنم و نمیتونم ویرایش کنم.چه جوری میتونم به این فایل دسترسی داشته باشم و تغییرش بدم؟

سلام ایزدی.

حتما یک جای کار داری اشتباه میکنی. بخش public_html بررسی کن.

سلام آقای آریا فر عزیز

من در سایت تست گوگل یعنی() سایت رو تست کردم اما ارور میده که میگه از فایل روبوت بلاک هستیم! اما مقاله شما رو خوندم کامل چند جا دیگه هم خوندم ، که ذکر کردین اگر فایل روبوت ندارید بسازید. اماسایت من پیش فرض یک روبوت داره که در فایل منیجر نیست، اصلا پیدا نمیشه! حتی بالای صفحه به نحوه های مختلف سرچ کردم که پیداش کنم اما نیست که نیست! عکس ارور هم آپلود کردم براتون لطفا کمکم کنید

سلام آرمان.

صورت مسئله گنگ هست و نمیشه نظر داد. با این حال فکر میکنم شما در یک جایی درست تشخیص ندادید و باعث شده صورت مسئله گنگ باشه. پیشنهاد میشه اگر تلاش کردید و به نتیجه نرسیدید به یک متخصص سئو دسترسی بدید تا اون هم یک بررسی کنه.

عکسی هم که فرستادید مربوط به داکیومنت های گوگل هست.

موفق باشی.

سلام وقت بخیر

من مشکلی برام پیش اومده من زمانی داخل روبوتس دات تی اکس تی دسترسی ربات های گوگل رو به سایت بسته بودم. الان به حالت دیفالت برگردوندم و دسترسی همه بازه اما همچنان گوگل سرچ کنسول به من اخطار میده که ربات ها توسط روبوتس دات تی اکس تی بلاک شدن و صفحات کراول نمیشن.

دلیلش چی میتونه باشه؟ ممنون میشم کمکم کنید.

سلام رایان.

باید به گوگل زمان بدی چون اصولا این فایل سمت گوگل کش میشه. به مرور این موضوع حل میشه (البته این پیش فرض رو دارم که تو درست کار رو انجام دادی)

من حدود 20 صفحه با خطای 404 دارم. میشه این لیست رو وارد این فایل کنم؟ مشکلی پیش نمیاد؟

برای چی؟!؟؟!؟؟!؟

برو خطای ۴۰۴ رو حل کن.

سلاو و درود

طی چن روز قبل فایل robots.txt را دسکاری کردم که منجر به ایندکس نشدن محصولات و مقاله جدیدم شد

بعد از کلی تحقیق این کد را جاگذاری کردم و هنوز صفحات جدیدم ایندکس نشده اند آیا این کد در تصویر مشکلی دارد؟

ممنون میشم کمک کنید با تشکر

سلام امین.

اصولا توی گوگل صفحات سریع پاک میشه ولی برعکس دیر انجام میشه.

پس باید زیاد صبر کنی و یا میتونی به گوگل اعلام کنی بیاد تو سایتت ( مقاله url inspection بخون)

کدت هم مشکلی نداره ولی تو کد نوشتی همه ربات ها به همه جای سایت دسترسی دارن. خب اگر قرار هست دسترسی به همه جا بدی من جات بودم دو خط کد رو کلا برمیداشتم. چون به شکل پیش فرض اگر چیزی ننویسی همین معنا رو میده و همه ربات ها به همه جا دسترسی دارن.

باسلام.

ممنون از مقاله جامعتون

یک سوال داشتم.

در حال حاضر وبسایت ما دو مدیریت محتوا جدا داره.

اصلی: اختصاصی هست

و بخش بلاگ با وردپرس.

به این صورت : example.com

و example.com/blog

برای اینکه بخش wp-admin رو ببندیم باید به چه شکل تعریف کنیم ؟

آیا Disallow: /blog/wp-admin/ درسته ؟

سلام وقت بخیر

باید یک فایل ربات توی روت اصلی سایت بسازید و به همون صورتی که اخر متن نوشتید درج کنید.

سلام خسته نباشید ممنون از مقاله خوبتون

یه سوال داشتم

من در فایل robots پست تایپ ها و تکسونومی هایی که نمیخام ایندکس بشن رو قرار دادم (چون صفحه ای ندارن و صرفا تو کد نویسی استفاده میشن) میخاستم بدونم کارم درست بوده یا اشتباه؟

ممنون میشم راهنمایی کنید

سلام وقت بخیر

من یک مورد بررسی کردم برام منطقی نبود که چرا برای price این کار کردید و به نظرم اشتباه هست.

بقیه موارد رو بدید به یک متخصص سئو تا با داشتن دسترسی به سرچ کنسول شما دقیق تر نظر بده تا یک وقت اشتباه جلو نرید.

موفق باشی.

price هم نام یکی از پست تایپ هام هست که قیمت ها رو مشخص میکنه که انگاری یکی از برگه هام هم همین اسم رو داره،این مورد باید درست بشه،جناب اگه این هایی که نوشتم صفحه نداشته باشن و اصلا نخام ایندکس بشن این کاری که کردم درسته دیگه؟فک نمیکنم مشکلی باشه

متاسفانه من از ساختار آدرس سایت شما و همینطور صفحاتی که دارید اطلاعاتی ندارم که بخوام نظر دقیق و درستی بگم.

اینکه نمیخواین برخی صفحات ایندکس بشن خب به کنار و اوکی هست ولی وقتی با همین کار میاین صفحات مهم رو هم از ایندکس در میارید مشکل درست میکنه، یک نمونه هم بررسی کردم و دقیقا همین یک نمونه این مشکل داشت.

با این حال با دقت و بررسی بیشتری از این فایل استفاده کنید تا آسیب به سئوی سایت خودتون وارد نکنید.

سلام

در مورد اینکه معمولا کدام پوشه ها و کدام فایل ها را دسترسی داده یا محدود کنیم مثل پوشه های فایل های js و scss و font و documents که فایل های پی دی اف قرار دارد و فایل های css و پوشه های img و … صحبت نشده ممنون میشم راهنمایی کنید که اگر محدود بشن خوبه با نشن و دلیل اینکار برای سئو هسا یا نه و اینکه google image مثلا ار تصاویر استفاده شده در صفحه استفاده میکنه توی سرچش و این مناسب هست یا نیست …

سلام میلاد.

هر منبعی (عکس، جاوااسکریپت یا سی اس اس و یا …) که برای لود یک صفحه کاربر نیاز هست (کاربر لاگین شده رو نمیگم) رو نباید روی گوگل ببندیم.

سلام و خسته نباشید

من یه سایت راه اندازی کردم که هنوز به طور کامل کاراش تموم نشده و خیلی از صفحات باید ویرایش یا حذف بشه تا نهایی بشه.

اما مشکلی که هست اینکه زمان راه اندازی فراموش کردم که گزینه ایندکس نشدن رو در ورودپرس تائید کنم و این باعث شده که کلی از صفحات بی ارتباط و غیر لازم خود قالب در گوگل ایندکس بشه(site:domain.com) حال با این وضعیت چطور می تونم این صفحات غیر مرتبط و پیش فرض قالب از ایندکس گوگل حذف کنم و بعد از اتمام کارهای سایت مجدد بتونم سایت نهای اینکس کنم. (آیا در فایل روبوت باید دسترسی به سایت کاملا دیس الو کنم یا کار دیگه ای؟)

ممنون میشم راهنمای بفرمائید.

تشکر

سلام آرمان.

از متا نوایندکس استفاده کنید.

سلام، افزونه یوآست چندین نقشه سایت برام ایجاد کرده( از جمله post-sitemap.xml و product-sitemap.xml و category-sitemap.xmlوpost_tag-sitemap.xml و author-sitemap.xml) آیا فقط باید یکی رو داخل فایل robots.txt قرار بدم یا همه نقشه های سایت رو قرار بدم؟؟؟

سلام جعفر.

یک دونه اصلی داره که تو قسمت سئو و بخش عمومی هست، میتونید اونو درج کنید. ولی با این حال درج همه این نقشه ها در این فایل هم مشکلی ایجاد نمیکنه.

شاد و پیروز باشی.

سلام و عرض ادب

تشکر بخاطر آموزشهای خوبتون

من یک سایت در پوشه public_html راه اندازی کرده ام. با استفاده از اددآن دامین هم یک سایت دیگه در یک پوشه مجزا که آن پوشه در ریشه قرار دارد راه اندازی کرده ام.

آیا باید فایل robots.txt را برای هر سایت و در داخل پوشه خود ایجاد کنم؟

آیا تداخلی پیش نمی آید؟

با تشکر از شما

سلام محمد عزیز.

بله باید برای هر دامنه جدا تعریف کنی.

نه تداخلی رخ نمیده اگر در پوشه درست ایجاد کنی.

موفق باشی.

با سلام

من فایل robots.txt را درست نساخته بودم و گوگل ادرس هایی که مربوط به فیلتر یک صفحه می شد مثلا ادرس هایی که دارای ؟ هستند را crawl کرده حالا فایل robot.txt را درست ساختم ایا این صفحات دابلیکیت از نتایج گوگل حذف می شود ؟ و چقدر زمان می برد ؟ اگر درست نمی شود باید چی کار کنم ؟

سلام. این موارد رو بهتره به کمک تگ canonical بهینه کنید و استفاده از فایل ربات پیشنهاد نمیشه.

موفق باشید

سلام الان من یک مشکل پیدا کردم واین است که یک قسمت به سایت من اضافه شده که بیشتر مطالب من داخل اون بخش است نام لینکش به این شکل است بعد نام دامنه /?cat=-1 این لینکش است من این را چطور در فایل ریبوتس نوفالو کنم که بعد هم از جستوجوی گوگل حذف کنم

2- آیا این دستور را من برای لینکی که گفتم وارد کنم Disallow: /*?* یا به این شکل هم میشه Disallow: /?cat=-1 الان من به شکل دوم وارد کردم

ایا موافق هستید باروش من ممنون میشم خیلی زود پاسخ بدید خیلی ناراحت این موضوع هستم

سلام شاهین جان. چرا ناراحتی؟ مشکل خاصی نیست که، مشکل داشت بسته میشه و در نتایج هم کم کم اعمال میشه و اگر مشکل نداشت میذاری همینطوری باشه.

مطمئن هستی محتوای این ادرس ها ارزش خاصی نداره؟ من حس میکنم این ادرس ها مربوط به دسته بندی های شما هست و ممکنه دسته بندی های شما مهم باشن.

سلام

جناب پوریا عزیز مجدد بعد چند سال این مشکل برام ایجاد شد و مجدد در گوگل نمایش داده شده ?cat=-1 شما فرمودید فکر میکنید برای دسته بندی ها باشه خیر برای وبلاگ است و من در سایتم وبلاگ را به نمایش نگذاشتم و در دسته ها مطالبم قابل مشاهده است آیا بهتر نیست ?cat=-1 دیسلو کنم ؟

سلام

سایت رو باید بررسی کرد تا بشه نظر درست داد. الان صورت مسئله بدون بررسی دقیق گنگ هست.

سلام و خداقوت

بابت آموزش های خوبتون سپاسگزاریم

جسارتا بنده تو این موضوع با اینکه همه موارد رو دقیق رعایت کردم و حتی تو سایت های دیگه ای هم هیچ مشکلی نداشتم، متاسفانه نمی دونم چرا تو سایت جدید به مشکل خوردم و با اینکه فایل روبوت یه شکل زیر هست:

User-Agent: *

Disallow: /wp-content/plugins/

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php

Allow: /wp-content/uploads/

اما گوگل میگه که دسترسی به نقشه رو نداره!

سلام طاها.

به نظر من که خیلی کار اشتباهی کردی wp-content/plugins رو بستی. با این حال بدون بررسی دقیق و اطلاعات نمیشه درباره نقشه نظری داد. ممکنه تشخیص شما مشکل داشته باشه و یا حتی ممکنه گوگل اشتباه تشخیص داده باشه.

پلاگین ها رو یعنی باز کنم؟

آخه دقیقا همین فایل رو برای همه سایت های دیگه هم استفاده کردم و تو هیچ کدوم به مشکل نخوردم، اما این یکی رو گوگل میگه دسترسی نداره! اصلا انگار فایل رو نمیشناسه!

البته اینو بگم که بینگ هم ناشناس زده بود ولی چن ساعت بعد اوکی شد و مشکلش برطرف شد. اما گوگل نه

ما که پلاگین ها رو نمیبندیم. ربات باید بتونه صفحات رو خوب لود کنه و برخی فایل ها در این مسیر هستند. گوگل انقدر هوشمند هست که بفهمه این فایل js هست و نباید در نتایج بیاره.

همون طور که قبلا اشاره کردم میتونه تشخیص اشتباه گوگل باشه که از این تشخیص های اشتباه زیاد داره. و همینطور نباید فکر کنید رفتار بر روی هر سایت یکسان هست. به همه مریض هایی که یک نوع بیماری رو دارن دکتر یک نوع دعوا رو تجویز نمیکنه. به شرایط فرد مثل سن و جنسیت و قدرت بدنی و سابقه فرد و شدت بیماری نگاه میکنه.

هر سایت هم به همین صورت هست. اینکه در یک سایتی اینطوری بوده اینطوری شده به این معنی نیست که در سایت دیگرم هم همون اینطوری بشه.

متشکرم از پاسخویی و راهنماییتون

مطلب آموزنده ای بود

سلام. خوشحالم براتون مفید بوده.

سلام و خسته نباشید

من یک سری صفحات وب سایتم به خاطر url هایی که کوکی لس سشن ها میسازن، به صورت های متفاوتی ایندکس شده. مثل این :

http://localhost/(F(blahblah)/mypageاگر توی روبوت، مثل مثال هشت که شما زدید و علامت سوال رو disallow کردید من (F( رو disallow بکنم این مشکل حل میشه؟

ممنون ازتون

سلام مینا. وقت بخیر

چرا این صفحاتی که اتوماتیک ساخته میشن رو طوری تعریف نمیکنید که متا تگ نو ایندکس بخوره؟ این روش بهتری هست. هر چند باید بررسی بشه و این حرف کلی هست.

درباره سوالت هم باید بگم اره میشه. البته این پاسخ من براساس صورت مسئله تعریفی شما بود.

ممنونم از اینکه وقتت رو در سایت ما سپری کردی. موفق باشی

ممنون بابت اینکه همیشه انقدر خوب و با حوصله پاسخ میدید. و تشکر از مقالات خوبتون درباره سئو.

خواهش میکنم مینا.

امیدوارم براتون مفید بوده باشه. باز اگر سوالی داشتید حتما بپرسید.

پایدار و شاد باشید.

سلام و احترام. سپاس از مطالب مفیدتان.

یکسری از صفحات و دایرکتوری های سایتم رو نمیخوام توی گوگل یا موتورهای جستجوی دیگه ایندکس بشه. البته سایتم توی دایرکتوری forum هستش و من اون مواردی رو که نمیخوام ایندکس بشه به این صورت توی robots.txt وارد کردم. آدرس سایت به این صورت هستش :

صفحه اصلی سایت :

http://site.comهستش که با html طراحی شده (فایل robot.txt در root سایت قرار دارد یعنی :http://site.com/robots.txt)بعد توی دایرکتوری forum هم یک cms جداگانه دارم که من توی فایل robots.txt مواردی که در دایرکتوری forum نمیخوام ایندکس بشه رو به این صورت وارد کردم.

ممنون میشم نظرتون رو بفرمایید.

دوم اینکه من توی بخش covarage برای صفحه register انجمن خطای Submitted URL marked ‘noindex’ دارم میگیرم. بعد از این خطا من در فایل robots.txt بالا کلا register.php رو disallow کردم. آیا با این کار این خطا برطرف میشه؟ و اینکه چقدر زمان میبره حدودا؟

پیشاپیش از راهنمای شما استاد عزیز تشکر میکنم.

سلام وقت شما بخیر باشه محمد عزیز.

ابتدا پیشنهاد میکنم این موضوع رو به یک متخصص سئو که امکان دسترسی به امار و سایت شما داره بسپارید، چرا که حس میکنم مسیر رو اشتباه میرید و صورت مسئله شما هم کافی نیست و باید دقیق بررسی کرد.

به هر حال خطای سرچ کنسول نوایندکس هست و ربطی به فایل robots نداره. این دو با هم فرق دارن. در مقاله فرق متاتگ با فایل ربات اشاره کردم. پیشنهاد میکنم ادرسی که نباید ایندکس بشه رو محدود میکنید و عدم دسترسی بدید ارور ۴۰۳ درج کنید و یا از متا تگ noindex استفاده کنید. این روش ها بهترین راه هستند برای اینکه در نتایج ادرسی رخ نده.

وقتی صفحه register خطای noindex داره یعنی متاتگ داره و میگه ایندکس نشو و وقتی شما disallow میکنید یعنی اشتباه در اشتباه. اشتباه اول این هست که این دو اصلا ربطی ب هم ندارن اشتباه دوم این هست که شما اینطوری محکم کاری کردید که دیگه نمایش داده نشه. البته شایدم هدفتون این باشه و سوال اشتباه پرسیده باشید.

با این حال امیدوارم پاسخ من براتون مفید باشه.

سلام

ممنون بابت مقاله خیلی خوبتون، واقعا مقالات شما بی نظیر است

دو سوال:

1. خود شما در این فایل سایت مپ رو نیز قرار داید آیا نیازی به این کار است؟

2. شما فهرست مطلب را چگونه ایجاد می کنید؟

سلام مهدی جان. ممنونم

۱ – پیشنهاد میشه این کار رو انجام بدید.

۲- با کدنویسی.

سلام. ممنون بابت این مقاله. همه چیز خیلی شفاف و خوب توضیح داده شده. مثل بقیه پست هاتون.

یه سوالی داشتم. من چند تا صفحه توی سایتم داشتم که به دلایلی مجبور شدم حذفشون کنم. اما با اینکه چند ماهی گذشته، هنوز توی نتایج پیدا میشن. آیا کار درستیه که آدرسشون رو disallow کنم؟؟

باز هم ممنون.

سلام. خواهش میکنم و خوشحالم براتون مفید بوده.

پیشنهاد نمیکنم. اگر صفحه ای نزدیک به موضوع اون صفحات پاک شده پیدا کردی بیا صفحات پاک شده رو ریدایرکت بکن به صفحات موجود.

ممنونم از راهنماییتون.

لطف کردید.

خواهش میکنم.

مطلب مفید و پرمغزی بود ولی شما نگفتی چطور جلوی رباتهای مخربو با استفاده از robots.txt میشه گرفت؟

و سوال دوم اینکه معنی اسلشی که اول کلمه میاد (یعنی سمت چپ ترین) چیه؟ یا به عبارتی تفاوت این دوتا چیه

/wpadmin/

/wpadmin

سلام امین جان. خوشحالم برات مفید بوده.

درباره سوال اول: چرا گفتیم داخل مقاله. شما خودت داری میگی ربات مخرب. مگه ربات مخرب در قالب چهارچوب عمل میکنه؟ در مقاله اشاره شده که ربات های اسپم و تخریب کن اصولا توجهی به این فایل متنی ندارند.

درباره سوال دوم: در ابتدا باشید بگم که بین wp و admin یک – وجود داره. و اینکه حالت /wp-admin/ شما استفاده کن

سلام ممنون از مقاله خوبتون. یک سوال چه مواردی را باید در robots. txt در نظر بگیرید. از افراد بسیار ی پرسید جوابی که شنیدم اینکه مواردی که رباتها نمی خواهید ببینند. خب نکته اینجاست چه مواردی را گوگل نباید ببینند.

سلام، خواهش میکنم.

بستگی به سایت داره. هر سایتی یک سری سیاستهای خاص داره و براساس همین سیاستها این فایل تعریف میشه. البته نحوه کدنویسی هم بر تنظیمات این فایل دخیل است. سوال شما بسیار کلی و به شدت بستگی به نوع سایت داره ولی یک مثال میزنم تا براتون کمی باز بشه. برخی سایتها مشکلات کدنویسی دارن و مثلا یک محتوا انتشار پیدا میکنه با چند ادرس در سایت دیده میشه، حال میان برخی ادرس های تکراری رو یک جا توسط این فایل میبندن تا محتوای تکراری حساب نکنه. (دو نکته: هر چند روشهای دیگه هم برای رفع این مشکل هست و اینکه بستن دسترسی ربات گوگل به معنی ایندکس نشدن نیست).

من متوجه نشدم! این روبات همون کاری رو انجام میده که کرال گوگل هم انجام میده؟

لطفا دوباره مطالعه کنید تا بهتر متوجه بشید. فایل ربات یک سری خطمشی برای کرال ها تعریف میکنه. مثلا فعلان صفحه رو کرال ها بررسی نکنن یا فعلان صفحه رو بررسی کنن و …

خیلی مفید بود ممنون از سایت بسیار خوبتون. خیلی کاربردی و مناسب سپاس

مثال هفت

رو ببنید

منظور من اونجا wp-includes هست که خیلی سایت های ایرانی میبندن، البته متن گنگ هست قبول دارم و باید ویرایش کنم. هر چند wp-admin هم بستگی به سایت داره و نمیشه برای کل سایتها بگیم مسدود کردنش خوبه یا بده.

سلام داخل مطلب مقاله از یوست سئو گذاشتید که گفته بود wp-admin رو نباید مسدود کرد ولی داخل فایل ربات سایت خودتون این کار رو کرده بودید دلیلش چی هست ؟

سلام سجاد، ادرس دقیق لطفا بگید که کجا گفتیم تا بررسی کنم. هر چند در این صفحه درباره wp-admin توضیح دادم و البته بهینه سازی سایت یا همون سئو برای هر سایتی متفاوت هست، شما برای هر غذایی یک اندازه نمک استفاده نمیکنی، هر غذایی فرق داره، سئو هم به همین شکل هست برای هر سایتی سئو خاص خودش رو میخواد. با این حال در خطی که بنده نوشتم نباید مسدود کرد رو لطفا بگید تا علت نوشتن رو بررسی کنم.

سلام

مطالب بسیار بسیار مفید شما را خواندم و خیلی جالب و کامل بود و نشان از حسن نیت و طبع بلند شما را دارد که در راستای انتقال اطلاعات تلاش بسیار دارید و خواهید داشت

ممنون می شوم سری هم به سایت بنده بزنید و اعلام نظر فرمایید

سایت شبکه تجاری دانشجویان ایران

bansi.ir

سلام، خواهش میکنم، موفق و پایدار باشید.

با عرض سلام و خسته نباشید من این ربات تکست رو استفاده میکنم :

از عزیزان درخواست دارم در صورت امکان بررسی کنند و اگر مشکلی در فایل من وجود داره به من اطلاع بدن ممنون

در مورد این دو تا دستور با وجود بسته بودن فایل : Disallow: /wp-includes/ حدود 1100 پست از من بلاگ شده بود توسط گوگل که این دو تا دستور رو گذاشتم پستها داره ایندکس میشه و به 200 تا پست کاهش یافته! کدها: Allow: /wp-includes/*.js$

Allow: /wp-includes/*.css$

در مورد این فایل هم : Allow: /wp-content/ یه مدتی بسته بود و پست هام توی وبمستر گوگل داشت بلاگ میشد که بازش کردم

در مورد admin-ajax.php این مورد رو گذاشتم یه مدتی و با خطا مواجه شدم و برداشتمش مورد بعدی میخواستم بدونم در آخر دستورات آیا وجود Allow: / بهتره یا نه ؟ یا نباشه هم ایرادی نداره

فایل من:

سلام، نمیشه همینطوری نظر داد چرا که باید دسترسی به سرچ کنسول داشت و پیشینه سایت رو مورد ارزیابی قرار داد تا بشه جواب مناسب داد ولی کاری که شما انجام میدید مثل خوددرمانی هایی هست که خیلی از افراد دارن انجام میدن و این میتونه عواقب نامناسبی داشته باشه.

وجود خیلی از دستورات بالا رو من درک نمیکنم ولی به هر حال با یک متخصص که آگاهی از سایت شما داره در تماس باشید.

با سپاس

سلام

مطالب سایت شما خیلی عالی و آموزنده است

من پاسخ خیلی از سوالاتم را دریافت کردم

واقعا ممنون از زحمات شما

سلام، خوشحالم در عمل مفید بوده. موفق و پایدار باشید.

با تشکر از پست خوبتون

ممنون بابت این که به سادگی و با توضیحات کامل مطالب را بیان کردید

امیدوارم موفق و موید باشید

سلام

تقریبا تمام مطالب سایت شما رو مطالعه کردم.

از سایت ما هم دیدن فرمایید .

ifix.ir

درود بر شما، موفق و پایدار باشید.

سلام

عالی و مفید

ممنون از سایت خوبتون

موارد آموزشی سئو را در سایت مهرارقام به نشانی blog.mehrargham.com بخوانید.

ممنون از سایت خوبتون

اگه میشه از سایت ماهم بازدید بفرمایید.

chapebaharestan.ir

تشکر از حضور شما، بر روی چینش محتوا بیشتر زمان بذارید و همینطور فونت و سئو محتوای سایت

موفق باشید.

سلام مطلب خوبی بود

فقط من فایل ربات رو میسازم تو هاست

با پسوند بک اپ میاد مشکل از کجاست

meshop2.com

سلام، خواهش میکنم

منظور شما از پسوند بک آپ رو متوجه نشدم، فایل robots.txt سایت شما بررسی شد و مشکل خاصی نداره، درضمن سرعت سایت شما به شدت کند است، روی این موضوع در جهت رونق کسب و کار خودتون کار کنید

موفق باشید

سلام

خسته نباشید

من robot.txt رو اوایل به اشتباهی فعال کرده بودم که کلا وبلاگم رو هیچ موتوری ایندکس نمیکرد،بعد از چند وقت فهمیدم و کد meta NAME=”ROBOTS” CONTENT=”ALL” / رو تو قالب وبلاگم قرار دادم و با webmaster هم صفحه mostanadd.blogfa.com/robots.txt رو remove کردم الان از کجا باید بفهمم که صفحاتن ایندکس میشه یا نه؟با توجه به اینکه هنوز کد های robot در robot.txt وجود داره

سلام، شما هیچ دسترسی به فایل robots.txt ندارید و نمیتونید تغییراتی در اون ایجاد کنید و حذف این فایل در وبمسترتولز عملی رو پیش نمیبره چرا که در سایت شما موجود هست.

متاتگ robots و فایل robots.txt در بلاگفا دسترسی کامل رو به ربات ها میدن برای ایندکس شدن صفحات، حال کافیه سایتتون رو در گوگل به این شکل سرچ کنید:

site:mizfa.com

صفحاتی که توسط گوگل جستجو میشن رو براتون میاره

بله ولی صفحات رو خودم از طریق webmaster ایندکس کردم(fetch as google)

خب پس مطالب شما ایندکس میشن در بلاگفا و مشکلی نیست، فقط ممکنه طول بکشه و اگر طول کشید همانطور که اشاره کردید میتونید دستی عمل فچ انجام بدید.

ممنون از مطالب خیلی خوب و مفیدتون

باتشکر

خواهش میکنم

عالی

موفق باشید

باسلام

ممنون از سایت خوبتون.

سلام، خواهش میکنم